Concentrez-vous sur la qualité des connaissances que vous fournissez aux outils AI

La guerre des modèles est une distraction

Depuis 2022, l’industrie technologique s’est engagée dans une véritable « course aux armements » autour des modèles d’intelligence artificielle générative. Microsoft/OpenAI avec GPT, Anthropic avec Claude, Google avec Gemini, Meta avec LLaMA, et plus récemment Microsoft Research avec Phi-4… chaque mois semble apporter son nouveau champion, plus grand, plus rapide, plus efficace que le précédent.

Pourtant, en tant qu’utilisateur, cette bataille ne devrait pas être votre priorité. Car l’expérience le montre : vous pouvez avoir accès au modèle le plus avancé du marché, mais si les données que vous lui fournissez sont de mauvaise qualité (incomplètes, fausses, obsolètes) ou si votre prompt est mal conçu, le résultat sera toujours médiocre.

En d’autres termes : la qualité de l’entrée (input) compte bien plus que le modèle choisi.

Pourquoi le modèle n’est plus le facteur déterminant

La croyance que « plus de paramètres = meilleure réponse » a dominé les débats. Mais les recherches récentes montrent que l’amélioration de la qualité des données d’entraînement ou des données d’inférence a un impact bien plus significatif que l’augmentation brute de la taille du modèle.

- Dans une étude phare, Gebru et al. (2021), Datasheets for Datasets, les chercheurs démontrent que la transparence et la documentation des données d’entraînement jouent un rôle crucial dans la performance et la fiabilité des systèmes d’IA.

- Bender et al. (2021), dans On the Dangers of Stochastic Parrots, alertent sur les risques d’amplification des biais et de génération de contenus incohérents lorsque la donnée source est de mauvaise qualité, indépendamment de la puissance du modèle.

Ces travaux soulignent une vérité essentielle : ce n’est pas seulement le modèle qui compte, mais la qualité et la pertinence des connaissances que vous mettez dans le système.

Les nouveaux protocoles : vers un écosystème d’agents interconnectés

Avec l’émergence de standards comme le Model Context Protocol (MCP) (Voir mon article à ce sujet) ou les protocoles Agent-to-Agent, nous entrons dans une nouvelle ère.

Qu’est-ce que cela change ?

Jusqu’à présent, l’utilisateur devait choisir un modèle (GPT-4, GPT-5, Claude, etc.) et l’interroger directement.

Demain, ce choix sera transparent :

- Votre application déléguera la requête à un Agent de Niveau 1, chargé d’évaluer si elle peut répondre immédiatement.

- Si ce n’est pas le cas, elle sollicitera un Agent de Niveau 2, spécialisé dans un domaine, qui pourra lui-même faire appel à d’autres agents.

- Une chaîne de raisonnement se crée alors, jusqu’à obtenir la meilleure réponse disponible.

Ce mécanisme ressemble au fonctionnement d’une équipe de travail :

- Vous posez une question à un collègue (Niveau 1).

- Si la réponse dépasse son domaine d’expertise, il consulte un expert (Niveau 2).

- Celui-ci peut, à son tour, interroger d’autres experts.

- Finalement, vous obtenez une réponse adaptée, soit directement, soit reformulée par le premier interlocuteur.

Une conséquence majeure

Peu importe si le modèle sous-jacent est GPT-5, Claude 3.5 ou Phi-4 : vous ne le saurez même plus. Ce qui fera la différence, c’est la pertinence et la qualité de vos données injectées dans le contexte de la requête. Ce qui permettra également aux éditeurs de choisir les modèles qui seront utilisés. Aujourd’hui, Microsoft utilise le modèle GPT pour son application Microsoft Copilot mais demain ? L’essentiel pour Microsoft est de garantir leur engagements de services tout en fournissant les meilleurs services possibles. Peut importe le modèle.

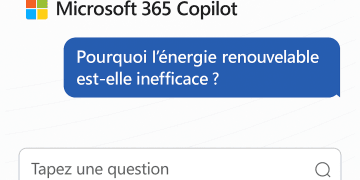

Garbage In, Garbage Out : un principe toujours valable

En informatique, le principe Garbage In, Garbage Out (GIGO) est vieux de plusieurs décennies : si vous fournissez des entrées incorrectes, les sorties seront mauvaises, peu importe la puissance de la machine.

Ce principe reste valable pour l’IA générative. La littérature scientifique sur le prompt engineering (Liu et al., 2023) montre que la formulation précise, le contexte explicite et la structuration des données d’entrée améliorent considérablement la qualité des résultats.

En clair :

- un prompt mal formulé → réponse vague, incohérente ou erronée ;

- une donnée obsolète → réponse périmée ;

- une donnée biaisée → réponse biaisée.

Recommandations pratiques pour les organisations

Pour maximiser l’efficacité des outils d’IA dans votre entreprise, vous devez déplacer le focus du « choix du modèle » vers la gestion de la connaissance et la qualité des inputs. Voici quelques recommandations :

- Travaillez vos prompts

- Soyez explicite : qui, quoi, quand, comment, pourquoi.

- Favorisez l’approche: Aide moi en me posant des questions (Encore mieux: En me posant des questions, une par une…)

- Structurez vos demandes en étapes claires.

- Intégrez le contexte métier dans vos formulations.

- Définissez des fiches de postes pour votre organisation qui définit les rôles de chaque services et personnes selon leur titres pour ensuite demander à Copilot de jouer un rôle spécifique dans votre prompt.

- Améliorez la qualité documentaire

- Centralisez vos connaissances (SharePoint, bases documentaires, graphes de connaissances).

- Vérifiez la fraîcheur et la fiabilité des informations.

- Supprimez les version obsolettes de votre OneDrive (La recherche M365, priorise les informations venant de OneDrive avant celles provenant de votre SharePoint).

- Utilisez les étiquettes pour aider Purview et cela aidera à structurer votre documentation.

- Documentez les sources (inspiré de Gebru et al., 2021).

- Mettez en place une gouvernance des données

- Ou se trouve les documents de référence ?

- Comment les différencier ?

- Qui met à jour ?

- Avec quelle fréquence ?

- Avec quel processus de validation ?

- Préparez vos équipes

- Formez vos collaborateurs au prompt design et à la logique des agents.

- Expliquez que le modèle est un détail technique ; l’essentiel réside dans la qualité et l’accessibilité des connaissances internes.

Les agents : ressources technologiques ou collaborateurs numériques ?

L’émergence des protocoles comme MCP ou Agent-to-Agent amène une question fondamentale : comment devons-nous considérer les agents au sein de l’entreprise ?

Aujourd’hui, la plupart des organisations voient encore l’agent comme une ressource technologique : un programme qui répond à des questions, exécute des tâches ou connecte des systèmes. On le configure, on l’invoque, et on mesure son efficacité en termes de performance technique.

Mais demain, avec la multiplication des agents spécialisés, chacun ayant :

- un domaine de compétence (RH, finances, support, veille technologique…),

- un contexte mémoire (les informations qu’il connaît et sait traiter),

- et une capacité à interagir avec d’autres agents et humains,

il devient de plus en plus pertinent de voir l’agent comme un collaborateur numérique à part entière.

Identité et profil dans l’entreprise

Pour qu’un agent soit pleinement intégré :

- il doit avoir son propre profil dans l’annuaire d’entreprise (Azure AD, Entra ID, etc.),

- il doit être identifié comme une entité avec ses propres droits d’accès, ses limites et ses responsabilités,

- il doit posséder une traçabilité de ses actions, afin que les utilisateurs sachent quand une décision ou une réponse provient d’un agent plutôt que d’un humain.

Cette reconnaissance d’identité n’est pas seulement technique. Elle change la culture de l’organisation :

- L’agent n’est plus un simple outil, mais un membre de l’équipe,

- On peut le former (via les données qu’on lui fournit),

- On peut lui assigner un rôle précis,

- Et surtout, on peut collaborer avec lui, plutôt que simplement « l’utiliser ».

Cette approche est déjà discutée dans les publications sur le Human-AI Teaming (Kamar, 2016 ; Dellermann et al., 2019), qui montrent que les meilleures performances émergent lorsque humains et IA travaillent comme des partenaires, chacun apportant ses forces et reconnaissant celles de l’autre.

En somme, la question n’est plus seulement technique : il s’agit d’un choix organisationnel et culturel.

Conclusion : la vraie bataille est ailleurs

La « guerre des modèles » est une distraction. Demain, grâce aux protocoles d’orchestration comme MCP ou Agent-to-Agent, vous n’aurez même plus à vous soucier du choix du modèle : les systèmes sélectionneront automatiquement le plus adapté.

Votre responsabilité sera ailleurs :

- soigner vos prompts,

- organiser vos connaissances,

- assurer la qualité et la fraîcheur de vos données,

- et surtout, redéfinir la place des agents dans votre organisation.

Les agents ne seront pas de simples outils techniques : ils deviendront des collaborateurs numériques avec une identité, un rôle, et une responsabilité dans vos processus.

L’avantage compétitif des prochaines années ne viendra donc pas seulement de l’IA en elle-même, mais de votre capacité à bâtir une culture de collaboration hybride entre humains et agents numériques, où chacun contribue à la qualité et à la pertinence des décisions.

Références

Gebru, T. et al. (2021). Datasheets for Datasets. Communications of the ACM, 64(12).