Avec l’avènement de Microsoft Copilot pour Microsoft 365, intégré dans des outils de la suite comme Word, Excel, PowerPoint, Teams, etc., les utilisateurs découvrent un nouveau moyen d’interagir avec la technologie via l’intelligence artificielle (IA). En s’appuyant sur des grands modèles de langage (LLM) comme GPT, Microsoft Copilot est conçu pour assister dans les tâches quotidiennes. Toutefois, pour tirer le meilleur parti de ces outils, un élément clé entre en jeu : la conservation de l’historique des conversations. Cet article explore comment Microsoft Copilot pour Microsoft 365 utilise (ou pourrait utiliser) l’historique des conversations, pourquoi c’est crucial pour améliorer la précision des réponses, et comment cela se compare à des solutions comme ChatGPT.

Le fonctionnement de Microsoft Copilot : l’importance de l’historique

Microsoft Copilot est propulsé par des modèles avancés de langage naturel comme GPT, développés par Open AI. Ces modèles fonctionnent en analysant les données d’entrée (prompts) et en générant des réponses basées sur des probabilités calculées à partir des informations disponibles. Cependant, un des éléments critiques qui impacte la précision des réponses est la quantité d’informations contextuelles que le modèle peut utiliser. Plus un modèle a d’informations sur la conversation, mieux il peut fournir des réponses pertinentes.

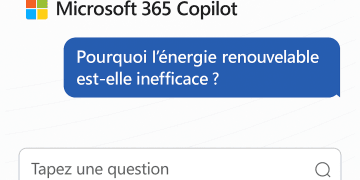

Dans le cas de Microsoft Copilot, l’historique des conversations joue un rôle central dans l’amélioration de l’expérience utilisateur. Lors des premières interactions avec Copilot, l’outil a très peu d’informations sur l’utilisateur, ce qui peut limiter la pertinence des réponses. Cependant, au fil du temps, Microsoft Copilot gratuit, présente les dernières interactions dans une liste disponible sur le site https://copilot.microsoft.com/. Microsoft Copilot pour Microsoft 365, lui, stocke les conversations dans un répertoire caché au sein de la boîte de réception Outlook de l’utilisateur. Bien que cet historique soit conservé, il n’est pas encore exploitable dans les interactions avec Copilot, contrairement à d’autres modèles comme ChatGPT où l’historique des conversations est activement utilisé pour contextualiser chaque nouveau prompt.

Comparaison avec ChatGPT : le rôle des sessions

ChatGPT, une application développée par Open AI, repose également sur des LLM comme GPT. Cependant, à la différence de Microsoft Copilot, ChatGPT utilise un système de sessions pour conserver l’historique des conversations. Chaque session est un fil continu, et l’historique y est accessible tout au long des interactions. Cela permet à l’algorithme d’analyser les prompts précédents, d’identifier les préférences de l’utilisateur, et de fournir des réponses de plus en plus adaptées à chaque nouvelle requête.

Dans ChatGPT, l’historique n’est pas seulement un enregistrement passif des conversations passées, mais un véritable moteur de contextualisation. Par exemple, si vous avez déjà mentionné votre préférence pour un type de contenu ou un sujet particulier, ChatGPT est capable de s’en souvenir et d’ajuster ses réponses en conséquence. Cela améliore non seulement la qualité des réponses, mais aussi leur pertinence pour l’utilisateur.

Dans Microsoft Copilot, bien que chaque session soit associée à un outil spécifique (Word, Excel, PowerPoint, etc.), l’historique des sessions reste cloisonné et inaccessible pour l’utilisateur. Cette séparation en silos empêche actuellement une continuité dans la compréhension des préférences et du contexte global de l’utilisateur. Il n’est pas possible, pour l’instant, de consulter, modifier ou supprimer cet historique directement, ce qui contraste fortement avec la transparence du système de sessions dans ChatGPT.

Le rôle de l’index sémantique dans Microsoft Copilot

Malgré ces limitations, Microsoft Copilot possède un atout majeur : l’index sémantique. Cet outil permet à Copilot d’analyser les données contenues dans votre environnement Microsoft 365 (comme les e-mails, documents, etc.) et de capter des « signaux » proches de l’utilisateur. Cela signifie que même si l’historique des conversations n’est pas directement utilisé comme dans ChatGPT, Copilot peut quand même contextualiser les informations en se basant sur les documents et communications précédentes.

Cependant, à mesure que l’utilisateur interagit davantage avec Copilot, la conservation de l’historique des conversations devient de plus en plus cruciale. Statistiquement, plus l’IA a accès à cet historique, plus elle peut affiner ses réponses en tenant compte de nuances personnelles ou professionnelles spécifiques à chaque utilisateur.

L’impact de l’historique sur les performances et les coûts

Un autre point important à considérer est que plus vous fournissez d’informations à un modèle LLM dans vos prompts, plus la requête devient coûteuse à traiter, à la fois en termes de temps de calcul et de ressources. Cette notion est particulièrement importante pour les grandes entreprises comme Microsoft, qui intègrent des solutions LLM tierces dans leurs produits.

Un prompt est essentiellement l’ensemble des données fournies par l’utilisateur au modèle. Ces données sont ensuite découpées en petites unités appelées « tokens ». Un token peut être un mot, une partie de mot, ou même un caractère de ponctuation. Le modèle GPT utilise ces tokens pour comprendre et générer des réponses. Chaque requête soumise à GPT utilise un certain nombre de tokens, et plus ce nombre est élevé, plus le coût de la requête augmente. Dans le cas de ChatGPT, l’optimisation des coûts est plus facile car OpenAI contrôle directement le modèle. Toutefois, Microsoft, en tant que client d’OpenAI, doit supporter le coût imposé par cette technologie, ce qui signifie que chaque token compte.

Dans cette optique, un historique de conversation bien géré et accessible permet de réduire la quantité de tokens à envoyer à chaque nouveau prompt. Au lieu de redonner continuellement le même contexte, l’IA pourrait s’appuyer sur l’historique existant, ce qui économise des tokens et rend l’utilisation plus rentable.

Conclusion

L’historique des conversations est essentiel à la fois pour la précision statistique des réponses fournies par les LLM comme GPT et pour l’optimisation des coûts liés à l’utilisation de ces modèles. Alors que ChatGPT exploite activement cet historique grâce à son système de sessions, Microsoft Copilot est encore limité par une gestion en silos des interactions, sans accès direct à cet historique pour l’utilisateur. Cependant, avec des outils comme l’index sémantique, Copilot peut déjà contextualiser certaines informations, et l’accumulation progressive des conversations permettra d’améliorer la précision des réponses.

À l’avenir, une gestion plus flexible et accessible de cet historique pourrait non seulement améliorer l’expérience utilisateur mais aussi réduire les coûts liés à l’utilisation des LLM, à la fois pour Microsoft et ses utilisateurs.

Ne manquez surtout pas l’évènement « Microsoft 365 Copilot: Wave 2 » pour en savoir plus sur les nouveautés de Microsoft 365 Copilot 😉 https://www.linkedin.com/events/microsoft365copilot-wave27236780403867443202/theater/