Enjeux et conséquences pour l’entreprise

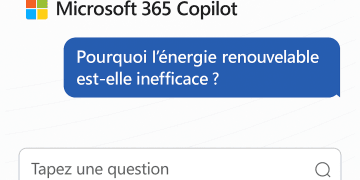

La montée en puissance des intelligences artificielles génératives (Et non « IAG » pour Intelligence Artificielle Générale…) telles que Microsoft 365 Copilot, ChatGPT ou d’autres modèles a considérablement transformé la manière dont nous produisons et exploitons l’information. Grâce à ces outils, les entreprises peuvent automatiser certaines tâches, enrichir leurs processus, gagner en productivité et accélérer leur prise de décision. Toutefois, un aspect demeure souvent sous-estimé : la qualité des contenus sur lesquels reposent ces IA pour s’entraîner, raisonner ou générer des réponses. Dès lors que l’information de base est obsolète, incomplète ou trompeuse, les résultats obtenus peuvent s’avérer contre-productifs, voire dangereux.

Cet article s’intéresse plus particulièrement au contexte de Microsoft 365 Copilot, qui puise ses informations aussi bien dans les données publiques d’Internet que dans Microsoft Graph, c’est-à-dire dans les contenus hébergés dans l’environnement Microsoft 365 du client. Dans un monde où la plupart des entreprises ont progressivement migré leurs données depuis des plateformes historiques vers le cloud, bien souvent sans un plan de gouvernance rigoureux, le risque de s’appuyer sur une « mauvaise qualité » de données est croissant. Les conséquences peuvent être lourdes pour l’entreprise : décisions stratégiques fondées sur des offres commerciales périmées, diffusion de processus industriels obsolètes, élaboration de rapports internes erronés, etc.

1. Contexte : l’essor des IA génératives et leur dépendance à la qualité des données

Les IA génératives, fondées sur des modèles de langage de grande taille (Large Language Models), se distinguent par leur capacité à produire des textes cohérents, des images, voire des vidéos à partir de simples requêtes. L’une de leurs forces réside dans l’analyse sémantique, qui leur permet de repérer des corrélations, d’identifier le contexte et de formuler des réponses pertinentes.

Cependant, ces modèles fonctionnent en grande partie comme des « éponges » : ils absorbent et apprennent de la masse d’informations à laquelle ils ont accès. Or, si ces informations sont obsolètes, fragmentées ou de mauvaise qualité, les algorithmes de l’IA peuvent générer des réponses présentant ces mêmes lacunes. Cela est d’autant plus vrai lorsque le modèle s’appuie sur des métadonnées incomplètes ou erronées, comme c’est parfois le cas dans des environnements d’entreprise mal gouvernés.

Dans le cadre de l’utilisation d’application d’IAG, l’entrainement du modèle est totalement indépendant de sa consommation par le biais d’une inférence. Je ne parle donc pas ici ‘utiliser des informations privées de l’entreprise pour entrainer un modèle quel qu’il soit.

Dans le cadre de Microsoft 365 Copilot, l’IA propose des réponses en intégrant des informations, on appelle cette étape le grounding, soit à partir de données provenant d’Internet et donc libre d’accès, soit à partir de données internes disponibles au sein de Microsoft Graph et donc disponibles dans votre environnement sécurisé. Si, d’une part, la fiabilité d’Internet est historiquement fluctuante (fake news, informations datées, redondances, etc.), les contenus internes ne sont pas nécessairement plus fiables s’ils sont mal organisés ou si-il ne sont pas disposés de manière chronologique. Si l’Intelligence Artificielle intègre aujourd’hui la chronologie dans son fonctionnement, c’est juste d’un point de vue statistique et non pas basé sur une conscience de ce qu’est le temps. Seul l’homme semble pour l’instant doté de cette conscience dans les limites de nos connaissances.

2. Le rôle de Microsoft Graph dans la fourniture de contenu

Microsoft Graph est un service qui connecte plusieurs applications et services de Microsoft 365, comme SharePoint, OneDrive, Teams, Exchange, etc. L’objectif est de proposer une vision unifiée de l’information, tout en s’appuyant sur un moteur sémantique. Une unification des systèmes de données pour faciliter l’accès et la connectivité aux données en brisant définitivement les silos existants auparavant entre les différents produits. Les algorithmes du Graph ne se contentent pas d’indexer des documents : ils évaluent la « distance » entre ces documents et les requêtes formulées pour déterminer leur pertinence.

Cette analyse de proximité permet de trouver rapidement des contenus connexes qui répondent à une question posée dans Copilot. Par exemple, si l’utilisateur cherche un compte-rendu de réunion portant sur un projet spécifique, Microsoft Graph est censé repérer les documents, e-mails et éléments Teams les plus proches de ce sujet.

Le problème surgit lorsque les contenus sont dépourvus de métadonnées fiables (dates de création, auteur, version, contexte de mise à jour), ou lorsqu’ils ont été migrés de façon massive sans conservations des attributs historiques. Dans ce cas, Microsoft Graph peut considérer comme « proche » un document qui n’est en réalité plus pertinent ou plus d’actualité. Les réponses fournies par Copilot s’en retrouvent biaisées.

3. Les migrations mal gouvernées : une source de données de mauvaise qualité

Au cours des dernières années, de nombreuses entreprises ont réalisées de grandes vagues de migrations de leurs données vers le cloud. L’enjeu prioritaire était souvent de moderniser l’infrastructure, de réduire les coûts et d’améliorer la collaboration. Malheureusement, ces migrations n’ont pas toujours été réalisées selon des méthodes garantissant la conservation des métadonnées essentielles dont celles de la chronologie.

Ainsi, il n’est pas rare de retrouver aujourd’hui des documents dans SharePoint ou OneDrive dont la date de création indique la date de la migration et non la date réelle de production, ou encore de constater que le nom de l’auteur s’est perdu en chemin. Dans les cas les plus extrêmes, la structure même des répertoires et l’historique des versions n’ont pas été préservés.

Pour l’IA générative, ce manque d’information contextuelle est problématique, car elle se fie fortement à ces indicateurs pour qualifier la pertinence et la fraîcheur d’un document. Un document qui a été véritablement rédigé en 2010, mais qui arbore une date de création 2023 suite à une migration bâclée, pourra être proposé comme « dernier document à jour » dans une recherche. Résultat : les utilisateurs risquent de se reposer sur un contenu périmé, sans forcément s’en apercevoir.

Imaginez: Vous demander à Copilot de vous décrire comment allumer du feu. Et copilot de vous répondre que vous devez frotter deux silex entre-deux…

4. Les risques pour l’entreprise

- Décisions stratégiques erronées

En fournissant des informations obsolètes ou incomplètes, l’IA peut conduire les décideurs à prendre de mauvaises décisions. Il peut s’agir d’un responsable de produit qui fonde ses prévisions sur des études de marché périmées, ou d’un service marketing qui déploie une campagne basée sur des offres commerciales n’existant plus. - Perte de confiance en l’IA et en la DSI

Si les collaborateurs se rendent compte que l’outil génère fréquemment des informations incorrectes ou dépassées, leur confiance envers l’IA et, par extension, envers le service IT ou la DSI, peut s’éroder. Cette perte de confiance freine l’adoption de nouvelles technologies et réduit l’efficacité des projets de transformation numérique. - Risques légaux et réglementaires

Dans certains secteurs (banque, santé, défense, etc.), l’utilisation d’informations erronées peut engager la responsabilité de l’entreprise. Un document réglementaire obsolète peut entraîner une non-conformité aux dernières normes en vigueur, exposant l’organisation à des sanctions ou à des actions en justice. - Réplication de contenus obsolètes

L’IA générative peut créer de nouveaux documents à partir de sources périmées, qui vont ensuite se propager dans l’environnement de l’entreprise. On assiste alors à une « pollution » informationnelle croissante : plus le temps passe, plus les documents obsolètes se multiplient et s’entremêlent à des informations valides. - Atteinte à l’image de marque

Une entreprise dont les systèmes fournissent des réponses anachroniques ou inadaptées aux clients peut voir sa réputation ternie. À l’ère des réseaux sociaux et de la viralité de l’information, une erreur de l’IA peut rapidement devenir un sujet de moquerie ou de critique publique.

5. De la mauvaise qualité à la mauvaise décision : mécanismes de propagation

Le fonctionnement même du moteur sémantique de Microsoft Graph amplifie le risque. Dans un environnement mal gouverné, des documents portant un même mot-clé ou traitant d’un sujet apparemment similaire seront jugés « proches ». De fil en aiguille, l’IA risque d’agréger des contenus épars dont la cohérence temporelle n’est pas vérifiée.

Prenons un cas concret :

- Situation initiale : Une entreprise utilise Microsoft 365 Copilot pour rédiger une note stratégique sur un nouveau produit.

- Recherche dans Graph : Copilot identifie plusieurs documents internes traitant de produits similaires, dont un vieux compte-rendu de réunion datant de 2015 (mais dont la date indiquée est 2022 en raison d’une migration).

- Analyse sémantique : Les termes de ce document (noms de composants, estimations de coûts, partenaires associés) sont jugés pertinents pour la requête en cours.

- Génération de la réponse : Copilot propose une synthèse qui inclut des informations dépassées concernant les prix, la disponibilité des partenaires ou la technologie utilisée.

Les rédacteurs, si pressés ou peu vigilants, peuvent intégrer directement ces données à leur note, qui sert ensuite de base pour une prise de décision. Toute la chaîne de production de connaissances est alors faussée.

6. Les spécificités des données issues d’Internet

En parallèle de l’intégration de données internes via Microsoft Graph, Copilot peut s’appuyer sur des informations provenant d’Internet. Or, le web foisonne de contenus de qualité très variable :

- Des articles de blogs sans mise à jour depuis des années

- Des faux sites ou des pages malveillantes destinées à la désinformation

- Des analyses superficielles qui ne s’appliquent plus dans un contexte évolutif

Ces sources externes peuvent être combinées avec des données internes tout aussi datées, formant un ensemble hétérogène. La capacité de l’IA à trier le vrai du faux dépend fortement de l’historique d’entraînement et des signaux qu’elle reçoit (popularité des sites, réputation, liens hypertextes, etc.). Toutefois, même les meilleurs algorithmes ne sont pas infaillibles, surtout si l’infrastructure interne ne fournit pas de contexte fiable (dates, versions, identités des auteurs, historique des révisions).

7. Comment l’entreprise peut-elle se prémunir du risque ?

La première étape, bien sûr, consiste à prendre conscience de ce risque. Trop souvent, les dirigeants et les responsables informatiques s’imaginent que la simple possession d’un outil d’IA de pointe assure automatiquement la pertinence et la fiabilité des résultats. En réalité, tout repose sur la gouvernance et la qualité de la donnée.

Parmi les bonnes pratiques à considérer :

- Mettre en place un plan de gouvernance documentaire

- Définir des règles claires de nommage, d’archivage et de conservation des métadonnées.

- Vérifier que chaque migration s’effectue en préservant autant que possible l’historique des documents (dates de création, versions, auteur, etc.).

- Mettre à jour régulièrement les contenus critiques

- Les informations clés, comme les offres commerciales, les référentiels réglementaires ou les brevets industriels, doivent faire l’objet d’un suivi attentif.

- Des audits périodiques peuvent aider à repérer des documents obsolètes ou incohérents.

- Former les utilisateurs

- Sensibiliser les équipes au fait que l’IA n’est pas infaillible et qu’il est nécessaire de toujours vérifier les informations considérées comme stratégiques.

- Encourager la collaboration entre les métiers et la DSI pour améliorer la qualité des contenus.

- Disposer d’une couche de validation humaine

- Pour les sujets à fort enjeu (juridique, stratégique, commercial), instaurer un processus de relecture et d’approbation manuelle avant la diffusion d’informations générées par l’IA.

- Ne jamais automatiser complètement la prise de décision sans garde-fou humain.

8. Vers une intelligence collective homme-machine

La question de la qualité des données dans un contexte d’IA générative ne se limite pas à un problème technique ; il s’agit d’un enjeu organisationnel et culturel. Pour éviter les écueils, l’entreprise doit considérer sa « dette informationnelle » accumulée au fil des migrations et des évolutions technologiques. Traiter cette dette, c’est non seulement assainir le passé, mais aussi préparer l’avenir en construisant un écosystème documentaire fiable, évolutif et transparent.

Les collaborateurs, quant à eux, doivent comprendre qu’ils ont un rôle crucial à jouer dans l’amélioration de la qualité de l’information. Plus l’IA sera confrontée à des contenus vérifiés, plus elle apprendra à fournir des réponses pertinentes. En retour, l’IA pourra soulager les équipes de tâches répétitives, faire émerger des connaissances jusque-là enfouies ou proposer des synthèses enrichissantes. Il s’agit donc d’un cercle vertueux où l’humain et la machine collaborent pour valoriser l’Intelligence Collective.

Conclusion : un risque majeur pour l’entreprise, mais des solutions existent

Le recours à Microsoft 365 Copilot et à d’autres IA génératives offre des opportunités considérables d’automatisation, d’innovation et de compétitivité. Néanmoins, les risques associés à l’utilisation d’informations de mauvaise qualité ne doivent pas être minimisés. L’entreprise peut souffrir d’erreurs stratégiques, de perte de confiance, de risques juridiques et d’une dégradation de son image, autant de conséquences potentiellement coûteuses et chronophages à gérer.

Comme nous l’avons vu, ces risques proviennent souvent de migrations réalisées sans cadre de gouvernance strict, ni véritable préoccupation pour la préservation des métadonnées et du contexte documentaire. Dans un monde où la sémantique et les liens entre documents jouent un rôle clé dans le fonctionnement de l’IA, disposer de données complètes et à jour n’a jamais été aussi essentiel.

Introduction au prochain article : bâtir un plan de gouvernance de l’héritage informationnel

Dans un prochain article, nous reviendrons plus en détail sur la méthode à mettre en place pour démarrer un plan de gouvernance de l’héritage informationnel. Nous verrons comment auditer les contenus existants, identifier les lacunes critiques, définir un schéma de métadonnées adapté et engager les équipes métiers dans cette démarche. Enfin, nous détaillerons comment articuler l’intervention humaine et celle de l’IA pour mettre en place une intelligence collective, où la machine et l’humain travaillent main dans la main pour produire et maintenir des contenus fiables, pertinents et à forte valeur ajoutée.

Le chemin vers une information de qualité est souvent semé d’embûches, mais il s’agit d’une étape incontournable pour exploiter pleinement le potentiel des IA génératives et assurer le succès à long terme de la transformation numérique de l’entreprise.